Как самостоятельно провести аудит своего сайта (для новичков). Часть Первая

Многие владельцы сайтов хотят понять насколько их проект качественен и соответствует ли он требованиям поисковых систем. Однако, не каждый способен провести аудит и выявить проблемы самостоятельно.

Самым правильным решением будет заказать аудит у профессионалов. Они смогут выявить все ошибки и дать рекомендации вашему проекту.

Но не каждый владелец сайта имеет на руках необходимую сумму денег. Особенно часто такое встречается у тех, кто решил только вот открыть свой бизнес и много средств ушло на создание сайта и решение других проблем.

В этой статье мы поможем вам самостоятельно провести базовый аудит сайта и выявить ряд проблем, решение которых обязательно поможет на ранней стадии развития вашего сайта.

Технический аудит – фундамент вашего сайта

Первое с чего стоит начать проверку вашего сайта – это техническая составляющая. В этой статье мы разберем именно этот момент.

Первым делом необходимо проверить следующее:

- Есть ли robots.txt и правильно ли он настроен.

- Наличие sitemap (карты сайта).

- Добавлен ли сайт в Яндекс Вебмастер и Google Search Console.

- Установлена ли Яндекс Метрика и Google Analytics.

- 301-редирект с дублей главной страницы и разделов.

- 404 код ответа сервера для несуществующих страниц.

- Скорость загрузки сайта.

- HTTPS

Для новичка, проверка этих пунктов может занять долгое время. Особенно сложно выполнить их проверку правильно. Сейчас мы разберем все эти пункты, чтобы вам было легко повторить их и на своем сайте и максимально верно сделать выводы после проверки.

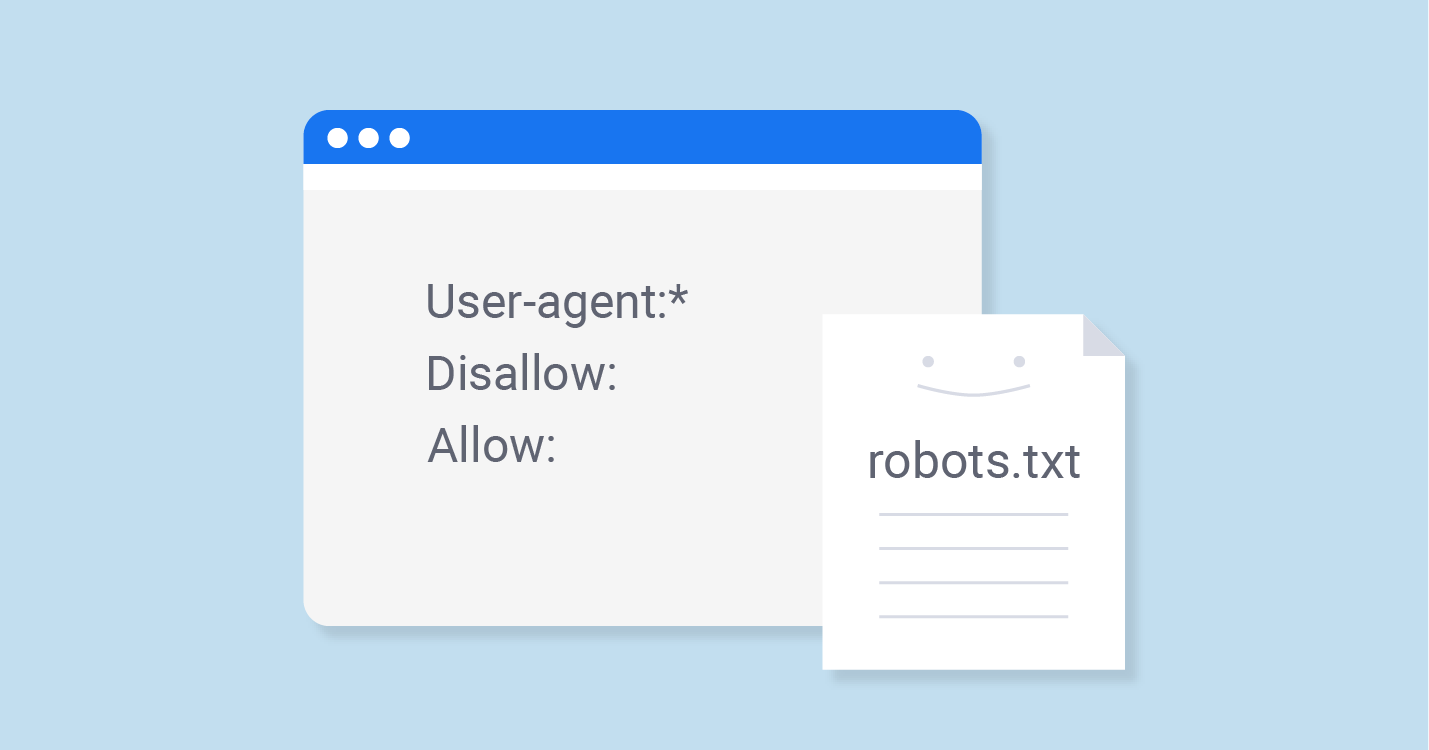

Есть ли robots.txt и правильно ли он настроен

Чтобы проверить наличие robots.txt на вашем сайте, необходимо в адресной строке вконце сайта добавить /robots.txt. Получится так – ваш сайт.ru/robots.txt

Далее смотрим, чтобы в robots были указаны основные директивы:

- User-agent * - указывает робота, для которого будут распространяться правила сканирования сайта.

- Disallow – указывает какие страницы, категории сайта нельзя индексировать.

- Sitemap – указывает путь к карте сайта

Наличие всех этих директив – обязательно! Можно сколько угодно заниматься своим сайтом, но малейшие ошибки в robots.txt могут привести к запрету индексирования вашего сайта, и он не будет появляться в поисковых системах.

Пример того, как не должно быть:

User-agent: *

Disallow: /

Такая настройка полностью закрывает сайт от индексирования.

Пример того, что должно быть минимум в robots:

User-agent: *

Disallow: /bitrix/

Disallow: /search/

Sitemap: https:// ваш сайт .ru/sitemap.xml

В данном примере все поисковые роботы буду сканировать ваш сайт за исключением админки (Disallow: /bitrix/) и страниц поиска на сайте (Disallow: /search/). При этом мы указываем на карту сайта (Sitemap: https:// ваш сайт .ru/sitemap.xml) ![]()

Важно понимать, что адрес админки, поиска на каждом сайте может быть разный. В данном примере показан классический вариант сайта на Битриксе

А вот ссылки на полезные статьи по robots.txt:

Яндекс справка - https://yandex.ru/support/webmaster/controlling-robot/robots-txt.html

Google справка - https://support.google.com/webmasters/answer/6062608?hl=ru

Наличие sitemap (карты сайта)

В настройках robots мы упомянули карту сайта. Ее наличие обязательно, так как она помогает поисковым системам сканировать необходимые и важные страницы вашего сайта. Составить такой файл можно самому с помощью программ Netpeak Spider или SEOFrog. Также есть различные сервисы, где можно загрузить список своих страниц, и они сгенерируют вам файл sitemap. После чего его надо будет залить в корневую папку вашего сайта и указать ссылку на файл в robots.txt

Важно, чтобы в карту сайта не входили мусорные страницы и URLs с 404 ошибками. Для новичка главное обнаружить наличие/отсутствие карты сайта, а реализацию задачи лучше уже передать программистам.

Добавлен ли сайт в Яндекс Вебмастер и Google Search Console

Очень простая и важная задача. К сожалению, новички не реализовывают даже этот пункт или ставят задачу только SEO-специалистам и разработчикам. Важно, чтобы наличие этих доступов было и у вас, чтобы видеть основную картину по проекту.

Вебмастера Яндекс и Google покажут вам основные ошибки и недочеты (если они есть) и укажут, насколько они критичны. Например, первые пункты, которые мы с вами разбирали, также отображаются в этих сервисах.

Отметим самые полезные разделы в вебмастерах для новичков или владельцев сайтов:

- Диагностика – диагностика сайта

Раздел показывает основные ошибки и рекомендации по вашему сайту.

- Индексирование – структура сайта

Показывает структуру вашего сайта. Сколько страниц робот нашел и сколько добавил в поиск.

- Структура - Файлы Sitemap

Тут можно посмотреть все карты сайта, которые нашел поисковый робот. Можно также добавить их вручную.

- Информация о сайте – Рациональность

Показывает к какому региону относится ваш сайт. Если видите, что информация в справочнике пустая – добавьте ее и укажите регион. Аналогично сделайте для вебмастера.

- Ссылки – внешние ссылки

Раздел стоит проверять, если ваша SEO компания покупает вам ссылки. Тут отображаются все источники, которые ссылаются на ваш сайт. Если не хотите углубляться, можно смотреть тут динамику в целом. Ссылки растут – хорошо.

Это основные пункты, которые стоит проверять каждому владельцу сайта и новичку в SEO. Добавить сайт в вебмастер очень просто. https://webmaster.yandex.ru/ - переходим сюда и добавляем адрес своего сайта. Далее выбираем любой удобный способ подтверждения владения сайта и ждем, когда информация будет подгружена в сервис. Аналогично все и для сервиса от Google - https://search.google.com/

Яндекс Метрика и Google Analytics

Теперь немного расскажем про Яндекс Метрику. Это основной инструмент для отслеживания самочувствия вашего сайта. Разделы с общим траффиком и поисковым траффиком отлично показывают, как развивается ваш проект.

Первым делом стоит посмотреть траффик из поиска. Сделать это можно перейдя в Отчеты – Стандартные отчеты – Источники – Поисковые системы. Тут можно выбрать интересующий вас период и оценить ситуацию с траффиком.

Советуем смотреть данные за весь период, так как они лучше всего показывают сезонность и ситуацию на данный момент. Если же смотреть только период продвижения, то может сложиться неправильное впечатление. Например, компания начала вас двигать в период сезонности и траффик растет сам по себе. Или же наоборот, в период, когда ваша продукция или услуги не пользуются спросом.

Если у вас еще стоит метрика на сайте, вот ссылка на рекомендации по установке - https://yandex.ru/support/metrika/quick-start.html

301-редирект с дублей главной страницы и разделов

Немаловажным является и настройка 301 редиректов для дублей главной страницы. 301 редирект – это перенаправление пользователя с одной страницы сайта на другую. Проверить, настроены ли редирект для основных дублей можно через вебмастера Google и Яндекс (о которых мы говорили ранее) или самому. Для проверки через вебмастер Google, зайдите в раздел Индекс - Покрытие - Исключено. Там будет список страниц, которые не попали в индекс, в том числе и по причине дублей. Для самостоятельной проверки основных дублей попробуйте перейти по ссылкам вашего сайта:

Дубли главнйо страницы:

- http://mysite.com/index,

- http://mysite.com/index/,

- http://mysite.com/index.php,

- http://mysite.com/index.php/,

- http://mysite.com/index.html,

- http://mysite.com/index.html/.

Дубли страницы категорий:

Категория доступна по ссылке http://mysite.com/catalog/dir/ или http://mysite.com/catalog/dir одновременно!

Если по этим ссылкам сайт открывается и не перекидывает вас на главную страницу сайта, значит редирект с данных дублей не настроен.

404 код ответа сервера для несуществующих страниц

Многие из вас, когда переходили по неправильной ссылке поучали страницу с ошибкой "страницы не существует" или "404 ошибка". Бывают такие моменты, когда содержимое страницы не соответствует ее действительности. Что это значит? Это значит, что напишут, что такой страницы нет, но для поисковых роботов данная информация не передается.

Как поисковый робот понимает, что страницы больше нет и ее не стоит добавлять в индекс? Он смотрит на код ответа сервера. Чтобы проверить, настроен ли у вас код ответа сервера для удаленных и несуществующих страниц – перейдите по этой ссылке и введите ваш сайт и в конце добавьте набор символов (Например, http://mysite.com/9734гергррп). Если сервис выдает не 404 ошибку, а 200 ОК, то значит пора писать своим разработчикам.

Скорость загрузки сайта

Для поисковых система важно, чтобы сайты как можно лучше решали интересы пользователей. Очень важным моментов является скорость загрузки сайта и его содержимого. Как быстро вы уходили с сайта, если он загружался очень долго? Никому не нравятся медленные сайты, поэтому если вы вкладываете средства в продвижение вашего проекта или только планируете начать продвигаться в поиске – уделите этому моменту особое внимание.

Даже самые классные сайты с большим товарным ассортиментом и удобной структурой, а также качественной SEO-оптимизацией загружаются по 5-10 секунд, то о хороших результатах речи и быть не может.

Как проверить? Воспользуйтесь бесплатным сервисом от GOOGLE - https://developers.google.com/speed/pagespeed/insights/

Вбиваем в строку главную страницу сайта и смотрим на итоговую оценку. Отчёт можно прислать разработчикам и попросить их устранить существующие проблемы, которые препятствуют скорости вашего ресурса.

Советуем, помимо главной страницы, проверить также и другие разделы, а также товарные страницы, так как проблемы везде могут быть разные.

HTTPS

Сейчас, наличие защищенного протокола HTTPS является одним из приоритетных моментов. Дело в том, что поисковые системы предлагают пользователям в выдаче те сайты, которые могут решить проблему пользователя или найти ответ на его вопрос, без риска перехвата ваших данных. К сожалению, в HTTP данные передаются в открытом виде и никак не защищены. На таких ресурсах, вся введенная ваша информация может подвергнуться взлому и быть украдена.

Если вы хотите, чтобы вашему сайту доверяли пользователи и поисковые системы, необходимо подключить HTTPS. Проверить его наличие очень просто – воспользуйтесь любым бесплатным сервисом или посмотрите адресную строку.

Итог

В этой статье мы разобрали самые простые и базовые моменты при анализе сайта. Как вы заметили, в названии статьи указано, что это первая часть. Скоро мы подготовим продолжение, где разберем уже SEO составляющую, приведем примеры и поможем вам быть более образованными в сфере поисковой оптимизации.

Также советуем вам прочитать статью про самые классные SEO сервисы и программы, которые помогут вам проести полный и подробный аудит.